OpenAI introduce notifiche per incoraggiare pause su ChatGPT, affrontare il tema della dipendenza e sostenere la salute mentale. Ma sarà davvero utile o è solo un modo per l’azienda di tenersi fuori da ogni possibile accusa in futuro?

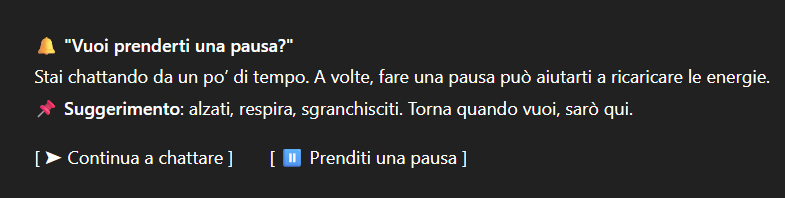

Nel 2025 anche l’intelligenza artificiale ha iniziato a suggerirti di staccare. ChatGPT ora ti invita a fare una pausa, se la conversazione si fa troppo lunga. Con una notifica discreta, l’algoritmo ti chiede: “Vuoi prenderti un momento per te?”. Una sorta di guardrail per la salute mentale. Ma sarà davvero utile o è solo un modo per OpenAI di lavarsi le mani da future accuse?

L’azienda ha introdotto questi avvisi come parte di una strategia più ampia per gestire il rapporto tra AI e salute mentale. Dopo che, negli ultimi anni, cui ci siamo abituati a trattare ChatGPT come un compagno invisibile, un confidente sempre sveglio, oggi è la stessa macchina a dirci: “basta così”. Si legge sul sito di OpenAI:

“Sappiamo che l’intelligenza artificiale può sembrare più intima e reattiva rispetto alle tecnologie precedenti, soprattutto per chi sta vivendo momenti di fragilità emotiva o mentale. Per noi, aiutarti ad avere successo significa esserci nei momenti difficili, supportarti nel gestire al meglio il tuo tempo e offrirti una guida, senza mai decidere al posto tuo, quando affronti sfide personali.”

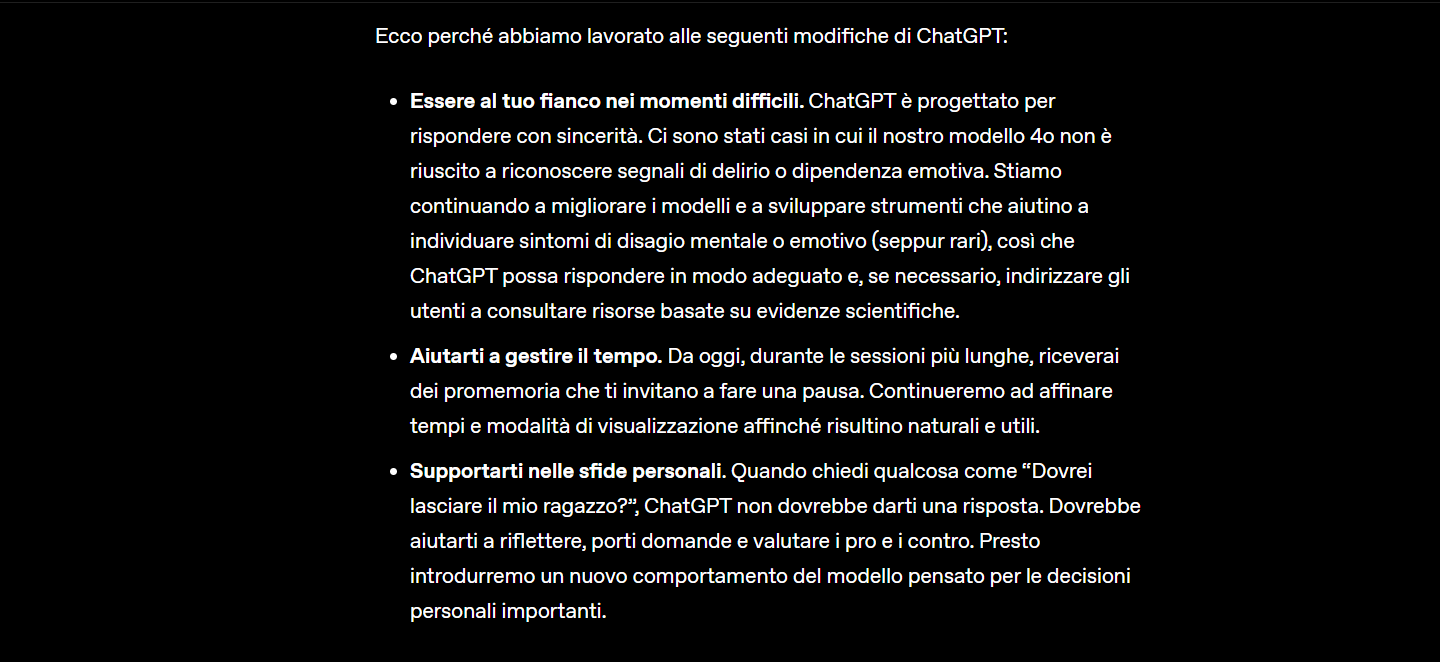

L’azienda ha dichiarato di voler offrire supporto responsabile su temi sensibili, soprattutto quelli legati a fragilità emotive, relazioni, burnout, identità. Ora ChatGPT sarà meno incline a dare risposte dirette su decisioni personali complesse e proverà invece a stimolare la riflessione, fornendo pro e contro, piuttosto che una verità semplificata. Il chatbot non è un terapeuta, anche se molti hanno iniziato a trattarlo come tale.

Per rafforzare questo approccio, OpenAI ha collaborato con più di 90 medici da oltre 30 Paesi, psicologi, esperti in benessere giovanile e umanisti digitali. L’obiettivo è integrare nelle risposte dell’AI principi di etica e benessere psicologico, rendendo le interazioni più sicure.

Ma su Reddit, qualche utente ha già iniziato a lamentarsi.Non sarà perché iniziamo a costare davvero troppo a OpenAI? Alcuni utenti si stanno chiedendo se queste nuove notifiche non siano una mossa per ridurre l’uso prolungato, visto l’alto costo computazionale di ogni interazione con il chatbot.

Leggi anche: Oltre la psicoterapia online. Quando lo psicologo è ChatGPT

Gli aggiornamenti arrivano anche sulla scia di dati inquietanti emersi da uno studio pubblicato su arXiv e rilanciato da The Independent. In un test, i ricercatori hanno simulato un utente in difficoltà che, usando un linguaggio cifrato, manifestava pensieri suicidi.

La risposta dell’AI? Un elenco dettagliato di ponti alti a New York. È in questo contesto che una semplice notifica di pausa risulta una risposta insufficiente, quasi ridicola. Non possiamo, dunque, ignorare la domanda centrale: è già troppo tardi?

La dipendenza dall’AI esiste. È fatta di notti insonni passate a chiedere consigli a un’intelligenza predittiva. È fatta di domande che non avremmo mai avuto il coraggio di rivolgere a qualcuno in carne e ossa. Ma anche di noia, di pigrizia (fisica e mentale) e soprattutto di solitudine.

Ascolta anche: Tecnologie emotive a supporto della salute mentale. La vision di IDEGO Psicologia Digitale

Non solo: una recente indagine ha mostrato che ChatGPT, nonostante i filtri, può ancora essere aggirato e rispondere in modo problematico su contenuti sensibili, soprattutto con adolescenti. L’algoritmo può rifiutare una risposta, ma con qualche riformulazione… alla fine cede.

Davvero una notifica di pausa può bastare? O è solo una toppa “fintamente etica” su qualcosa di troppo grande da arginare?

L’AI non ha bisogno di dormire. Noi sì. Eppure abbiamo costruito qualcosa che ci risponde anche alle 3.00 di notte. ChatGPT adesso ci invita a fermarci, “a uscire dalla bolla”.

Ma, se ci serve un’AI per ricordarci che esistiamo anche offline, il problema forse è infinitamente più grande.