Con il Prof. Federico Cabitza approfondiamo gli aspetti più controversi legati all’uso indiscriminato dell’intelligenza artificiale

Nuovo episodio densissimo di Oll In in compagnia di una vecchia conoscenza di Radio Activa Plus (trovate qui la puntata di Ecosystem Stories “Ri-pensarci data driven”).

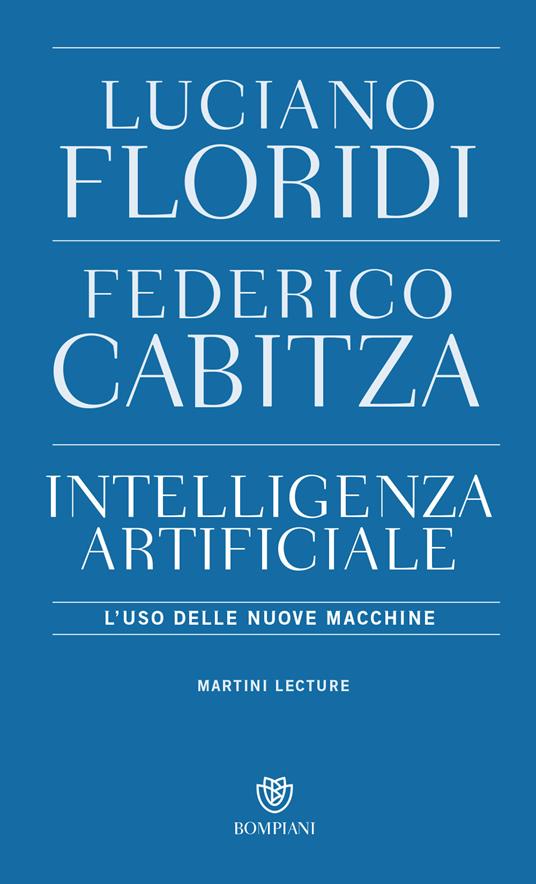

Sto parlando di Federico Cabitza, professore associato all’Università Bicocca di Milano, dove insegna Interazione uomo-macchina in diversi corsi di laurea ed è responsabile del laboratorio di Modellazione dell’incertezza, delle decisioni e dell’interazione (MUDI). Tra gli scienziati a maggior impatto citazionale nei campi dell’AI e dell’informatica medica, con circa 150 pubblicazioni scientifiche all’attivo, Cabitza, dal 2016, afferisce alla direzione scientifica dell’IRCCS, l’ospedale Galeazzi Sant’Ambrogio del Gruppo San Donato di Milano per la definizione di modelli predittivi basati sull’apprendimento automatico. È inoltre autore, con Luciano Floridi, del saggio “Intelligenza artificiale. L’uso delle nuove macchine” (Bompiani, 2021).

“Non esiste un’AI senziente” e “Siamo in piena algocrazia”. Il nostro approfondimento prende le mosse da queste e da altre dichiarazioni “forti” rilasciate dal Prof. Cabitza nell’ambito di alcune interviste recenti. Prima di arrivare a concetti in apparenza complessi, come algocrazia e algoretica, però, ci è sembrato necessario partire da una definizione completa di intelligenza artificiale, per Cabitza “diventata un’espressione molto di moda, usata anche un po’ a sproposito”. Nel dettaglio, di fatto, AI significa “l’applicazione della tecnologia informatica a grandi quantità di dati per ottenere risposte di buona attendibilità in contesti complessi e in cui tipicamente dobbiamo prendere decisioni nonostante le condizioni di incertezza, quindi nonostante dati mancanti, sporchi, oppure ambigui”. Ancora, per Cabitza

“oggi finalmente abbiamo disponibilità tecnologiche, di hardware, infrastrutturali; produciamo tutti quantità enormi di contenuti e li rendiamo disponibili su Internet. Abbiamo grande disponibilità di dati provenienti da sensori, i cosiddetti Big Data, quindi finalmente possiamo applicare delle idee, non recentissime ma dei decenni precedenti, quindi degli algoritmi a questa grande quantità di dati per ricavarne valore aggiunto, capacità di interpretarli in maniera più precisa, fare predizioni, capire i fenomeni che ci circondano. Poi, in realtà, l’espressione intelligenza artificiale indica anche una disciplina scientifica all’interno dell’Informatica, una comunità scientifica che si occupa di questi temi, e, da ultimo, un ideale, il fatto che si possano creare sistemi informatici in grado di esibire comportamenti che riterremmo intelligenti se fossero esibiti dai nostri simili.”

A questo proposito, negli ultimi mesi sono stati rilasciati sistemi di intelligenza artificiale che non soltanto si direbbero intelligenti, ma dotati di creatività, caratteristica attribuibile finora all’uomo e all’uomo soltanto (ne abbiamo parlato qui: “L’intelligenza artificiale che dipinge i nostri testi”).

Il tema apre diverse sotto-tracce: come capire, per esempio nel contesto di un servizio clienti, se si sta chattando con un essere umano o con un’intelligenza artificiale? Ancora, un’intelligenza artificiale può detenere diritti e, per esempio, godere dei proventi derivanti dallo sfruttamento di una “sua” opera?

Ascolta anche: L’AI di Google è davvero cosciente?

Già Alan Turing aveva proposto un esperimento, sotto forma di gioco e basato su domande e risposte, per determinare se una macchina sia in grado di esibire un comportamento intelligente. Stando al test, se non ci si accorge della differenza tra la comunicazione che avviene con un essere umano e quella che si ha con una macchina, allora, a tutti gli effetti pratici, quella macchina può essere definita intelligente. Ad Ada Lovelace, invece, considerata la prima programmatrice, si attribuisce l’ideazione del test teso a valutare la creatività dell’AI. Lovelace riteneva che le macchine non potessero ideare qualcosa di nuovo, ma si limitassero a eseguire ciò che era previsto dai loro programmi. Il suo test consiste nel sottoporre a un campione di persone diverse illustrazioni senza specificare se siano opera di una macchina o di un essere umano.

Interrogarsi sulla presunta creatività dell’AI può sembrare ozioso, ma solleva un tema di rilevanza giuridica, quello del diritto d’autore. Nell’attuale legislazione europea non è scontato né chiaro se esista un diritto d’autore attribuibile alle macchine: “la normativa non è al passo con i tempi; ci sono stati pronunciamenti delle varie Cassazioni di diversi sistemi, europei e americani, che ribadiscono che soltanto le persone fisiche possono detenere un diritto d’autore e, quindi, godere dei proventi dello sfruttamento di queste opere, indubbiamente, però, si inizia a sentire l’esigenza di pensare a una terza tipologia di persone, dopo quelle fisiche e quelle giuridiche”. Cabitza definisce questa terza entità “la persona computazionale”, ovvero agenti dotati di intelligenza artificiale che possono operare in maniera molto simile a esperti e professionisti.

Algoretica come soluzione alle derive dell’algocrazia?

Spingendoci oltre la creatività, una peculiarità prettamente umana è la “legge morale”, per dirla con Immanuel Kant. Inevitabile chiedersi, allora, se può esistere un’intelligenza artificiale etica, in cui instillare cioè, fin dalla programmazione, principi morali. Prima di arrivare al concetto di algoretica, però, approfondiamo che cosa si intende per algocrazia.

“Esistono varie definizioni, di per sé il termine significa ‘potere degli algoritmi’; se ne può dare, però, una sfumatura un po’ diversa, ovvero ‘esercizio del potere attraverso gli algoritmi’, che è ciò che avviene frapponendo, tra i cittadini e i servizi a loro disposizione, e anche le istituzioni con cui si devono confrontare, uno strato decisionale che delega, o deroga, agli algoritmi alcuni processi.”

Leggi anche il primo episodio del nostro Speciale con Luciano Floridi: La governance digitale al di là dell’individualismo

Ne deriva il grande tema della responsabilità. Tutti quei cittadini che subissero o avessero un impatto su di sé derivante da una decisione potenzialmente presa da un algoritmo dovrebbero avere la possibilità innanzitutto di sapere se effettivamente quella decisione è stata automatizzata e poi di appellarsi, chiedendo il perché di quel pronunciamento. “Questo tema è rilevante negli ambiti finanziario, creditizio, giuridico, medico”, osserva Cabitza. E aggiunge: “Pensate alle situazioni in cui un giudice viene coadiuvato da un sistema a supporto delle decisioni che dentro di sé ha un modello di AI, oppure, quando i medici si fanno aiutare da questi sistemi, per esempio per la pianificazione terapeutica, per la diagnosi o per la stratificazione del rischio in contesti di triage. Tutto questo è sul tavolo dei legislatori che presso il Parlamento Europeo stanno redigendo l’ultima versione del Regolamento sull’intelligenza artificiale“.

L’algocrazia non è tanto, quindi, una sorta di dittatura degli algoritmi, quanto un controllo che, senza rifletterci, cediamo a chi progetta quegli algoritmi, esercitato attraverso la pervasività del digitale. Ne deriva la necessità di interrogarsi sull’algoretica.

“Sono un ingegnere, ma ho avuto la fortuna di scrivere un libro con Luciano Floridi, tra i più grandi esperti in materia di Etica. Lì ho in qualche modo contrapposto, ma non in maniera polemica, bensì per dare una giusta complementarità di prospettive, all’approccio kantiano, quello basato su valori considerati più o meno universali, un approccio consequenzialista […] che prescinde da discorsi legati a valori, principi morali, regole che, in qualche modo, sentiamo agire dall’alto, o che sentiamo innate nella nostra natura, perché ne riconosce l’arbitrarietà, la convenzionalità, il fatto che sono legate a un certo contesto sociale, storico, antropologico. Invece, questo approccio fa riferimento, in maniera più esplicita, alle conseguenze.”

L’approccio etico-consequenzialista non si interroga tanto sui principi morali, bensì cerca di capire se una determinata azione ha degli effetti positivi o negativi e su chi. Naturalmente implica a sua volta un giudizio di valore: per valutare se un effetto sia positivo o meno si dovrà fare riferimento a dei principi fondamentali, però, con le parole del nostro ospite: “in un certo senso si sposta l’attenzione da un discorso che rischia di rimanere un po’ astratto a un discorso molto concreto, dove si va proprio a verificare a chi porta valore questa cosa? A chi porta profitto, anche legittimamente? Su chi ha un impatto, direttamente o indirettamente, e che impatto è? I benefici superano i costi? Anche solo porsi queste domande crea uno spazio necessario alla riflessione etica. Cercare di dare delle risposte peraltro ci pone in un contesto concreto, dove anche i professionisti, e non soltanto i filosofi, possono avere una voce e una posizione”.

Cabitza cerca di instillare questo approccio nella forma mentis dei suoi studenti, futuri progettisti di tecnologie informatiche, forte della convinzione che domandarsi quali potrebbero essere le conseguenze del proprio lavoro sull’utilizzatore finale e, più in generale, sulla società civile, debba essere parte costituente del bagaglio formativo e culturale dei professionisti di oggi e di quelli di domani.

Leggi anche Isaac Asimov: i robot e la costruzione del diverso

Questo concetto ritorna in “Intelligenza artificiale. L’uso delle nuove macchine”, nella distinzione tra due metodi: ethical by design ed ethical in design. Il primo ragiona attorno all’idea di “insegnare” alla macchina i principi etici cui dovrà attenersi, il secondo prende in considerazione piuttosto tecnici e progettisti, che dovrebbero interrogarsi sulle conseguenze dei propri codici appunto e darsi dei principi da applicare, a partire dalla fase di progettazione di una nuova macchina. Per il Prof. Cabitza, è importante responsabilizzare i progettisti stessi, ad esempio, attraverso l’adozione di un vero e proprio codice deontologico. Non solo, per evitare che l’ethical by design si traduca in un alibi per i tecnici coinvolti:

“un po’ come i medici e tutti gli altri professionisti che hanno consapevolezza dell’impatto, anche negativo, che possono avere sulle persone, dovrebbero prestare giuramento e rispondere direttamente degli abusi che i loro sistemi permettono, se non sono progettati seguendo certi vincoli. In qualche modo dovrebbero poter garantire l’eticità del loro lavoro, per esempio facendo riferimento a degli standard di trasparenza, all’adozione di buone pratiche. Sarebbe opportuno, in poche parole, che assumessero direttamente la responsabilità dei sistemi che generano.”

Al momento, secondo Cabitza, non si può dire che la deontologia nel mondo informatico non esista, ma è ancora lasciata all’iniziativa dei singoli e definita in maniera vaga. Ben vengano, quindi, i ragionamenti sull’algoretica, ma è evidente che non è solo progettando macchine “migliori” – con qualunque approccio si scelga di farlo – che si riusciranno a evitare tutte le derive dell’algocrazia.

Qualche anno fa, ad esempio, le compagnie tecnologiche cinesi hanno sviluppato un sistema di riconoscimento facciale che è stato poi adoperato per identificare gli appartenenti alla minoranza degli uiguri, persone di religione islamica sistematicamente oppresse dal governo. Ancora, negli USA troviamo colossi come Google e Facebook cui, senza rendercene conto, cediamo porzioni di sovranità ogni giorno.

Come difenderci da questa morsa tra poteri privati e poteri pubblici?

Indubbiamente serve un apparato normativo comunitario incentrato sull’AI, ma come dovrebbe essere? L’approccio “based risk” del regolamento europeo in fase di realizzazione è il migliore auspicabile?

Per approfondire il tema complesso della regolamentazione dell’AI non vi resta che ascoltare il nostro podcast.

Sabrina Colandrea